Hugging Face ha agregado Groq a sus proveedores de inferencias de modelos AI, llevando el procesamiento de rayos al popular Hub de modelos.

La velocidad y la eficiencia se han vuelto cada vez más cruciales en el desarrollo de la IA, con muchas organizaciones que luchan por equilibrar el rendimiento del modelo con el aumento de los costos computacionales.

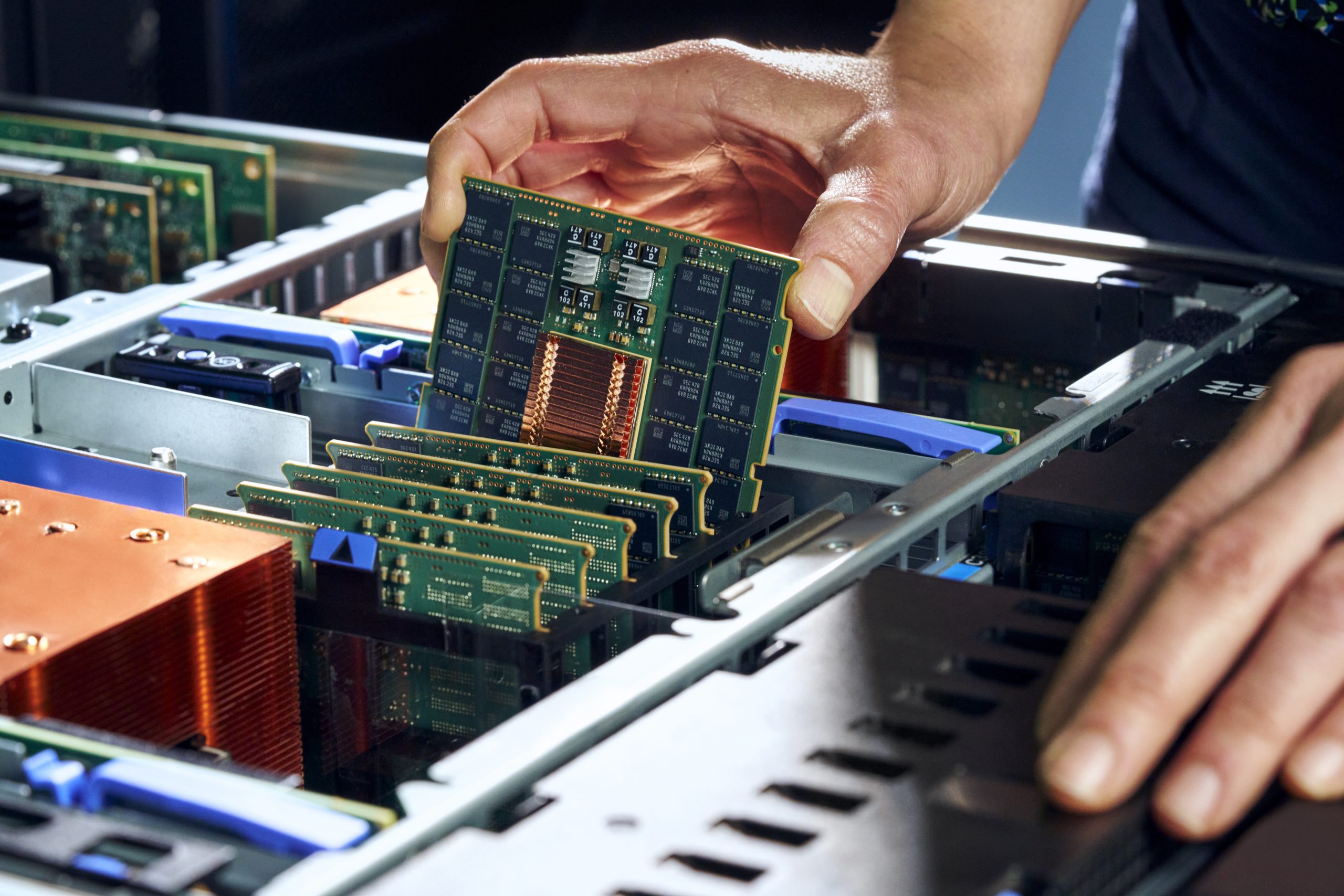

En lugar de usar GPU tradicionales, Groq ha diseñado chips especialmente diseñados para modelos de idiomas. La Unidad de Procesamiento de Lenguas de la Compañía (LPU) es un chip especializado diseñado desde cero para manejar los patrones computacionales únicos de los modelos de lenguaje.

A diferencia de los procesadores convencionales que luchan con la naturaleza secuencial de las tareas del lenguaje, la arquitectura de Groq abarca esta característica. El resultado? Los tiempos de respuesta reducidos dramáticamente y un mayor rendimiento para aplicaciones de IA que necesitan procesar el texto rápidamente.

Los desarrolladores ahora pueden acceder a numerosos modelos populares de código abierto a través de la infraestructura de Groq, incluidos Meta’s Llama 4 y QWQ-32B de Qwen. Esta amplitud de soporte modelo asegura que los equipos no sean sacrificando capacidades para el rendimiento.

Los usuarios tienen múltiples formas de incorporar Groq en sus flujos de trabajo, dependiendo de sus preferencias y configuraciones existentes.

Para aquellos que ya tienen una relación con Groq, abrazar la cara permite una configuración directa de claves de API personales dentro de la configuración de la cuenta. Este enfoque dirige las solicitudes directamente a la infraestructura de Groq mientras se mantiene la interfaz de la cara de abrazo familiar.

Alternativamente, los usuarios pueden optar por una experiencia más práctica al dejar que abrazar la cara manejen por completo la conexión, con cargos que aparecen en su cuenta de la cara abrazada en lugar de requerir relaciones de facturación separadas.

La integración funciona sin problemas con las bibliotecas de clientes de Hugging Face para Python y JavaScript, aunque los detalles técnicos siguen siendo refrescantemente simples. Incluso sin sumergirse en el código, los desarrolladores pueden especificar Groq como su proveedor preferido con una configuración mínima.

Los clientes que usan sus propias claves API Groq se facturan directamente a través de sus cuentas Groq existentes. Para aquellos que prefieren el enfoque consolidado, abrazar la cara pasa a través de las tasas de proveedores estándar sin agregar marcado, aunque señalan que los acuerdos de intercambio de ingresos pueden evolucionar en el futuro.

Abrazo incluso ofrece una cuota de inferencia limitada sin costo, aunque la compañía naturalmente alienta a la actualización a Pro para aquellos que hacen uso regular de estos servicios.

Esta asociación entre abrazar Face y Groq surge en un contexto de competencia intensificadora en la infraestructura de IA para la inferencia del modelo. A medida que más organizaciones pasan de la experimentación a la implementación de producción de sistemas de IA, los cuellos de botella en torno al procesamiento de inferencias se han vuelto cada vez más evidentes.

Lo que estamos viendo es una evolución natural del ecosistema AI. Primero llegó la carrera para modelos más grandes, luego llegó la prisa por hacerlos prácticos. Groq representa el último: hacer que los modelos existentes funcionen más rápido en lugar de solo construir otros más grandes.

Para las empresas que pesan opciones de implementación de IA, la adición de Groq al ecosistema de proveedores de Hugging Face ofrece otra opción en equilibrio entre los requisitos de rendimiento y los costos operativos.

La importancia se extiende más allá de las consideraciones técnicas. La inferencia más rápida significa aplicaciones más receptivas, lo que se traduce en mejores experiencias de usuario en innumerables servicios que ahora incorporan asistencia de IA.

A medida que AI continúa su marcha hacia aplicaciones cotidianas, asociaciones como esta resaltan cómo el ecosistema tecnológico está evolucionando para abordar las limitaciones prácticas que han limitado históricamente la implementación de IA en tiempo real

¿Quiere obtener más información sobre AI y Big Data de los líderes de la industria? Echa un vistazo a AI y Big Data Expo que tendrá lugar en Amsterdam, California y Londres. El evento integral está ubicado en otros eventos líderes, incluida la Conferencia de Automatización Inteligente, Blockx, la Semana de Transformación Digital y Cyber Security & Cloud Expo.

Explore otros próximos eventos y seminarios web de tecnología empresarial alimentados por TechForge aquí.